Un hombre en Reino Unido fue sentenciado a prisión por generar pornografía con el rostro de su hija, así como de actrices y cantantes de talla internacional llevando procesos exhautivos para eliminar su rostro de videos sexualmente explícitos y mujeres en situación de vulnerabilidad viviendo venganzas pornográficas sin obtener justicia; la realidad del deepfake ha llegado junto con la Inteligencia Artificial para trasgredir y violentar todo derecho humano al consentimiento.

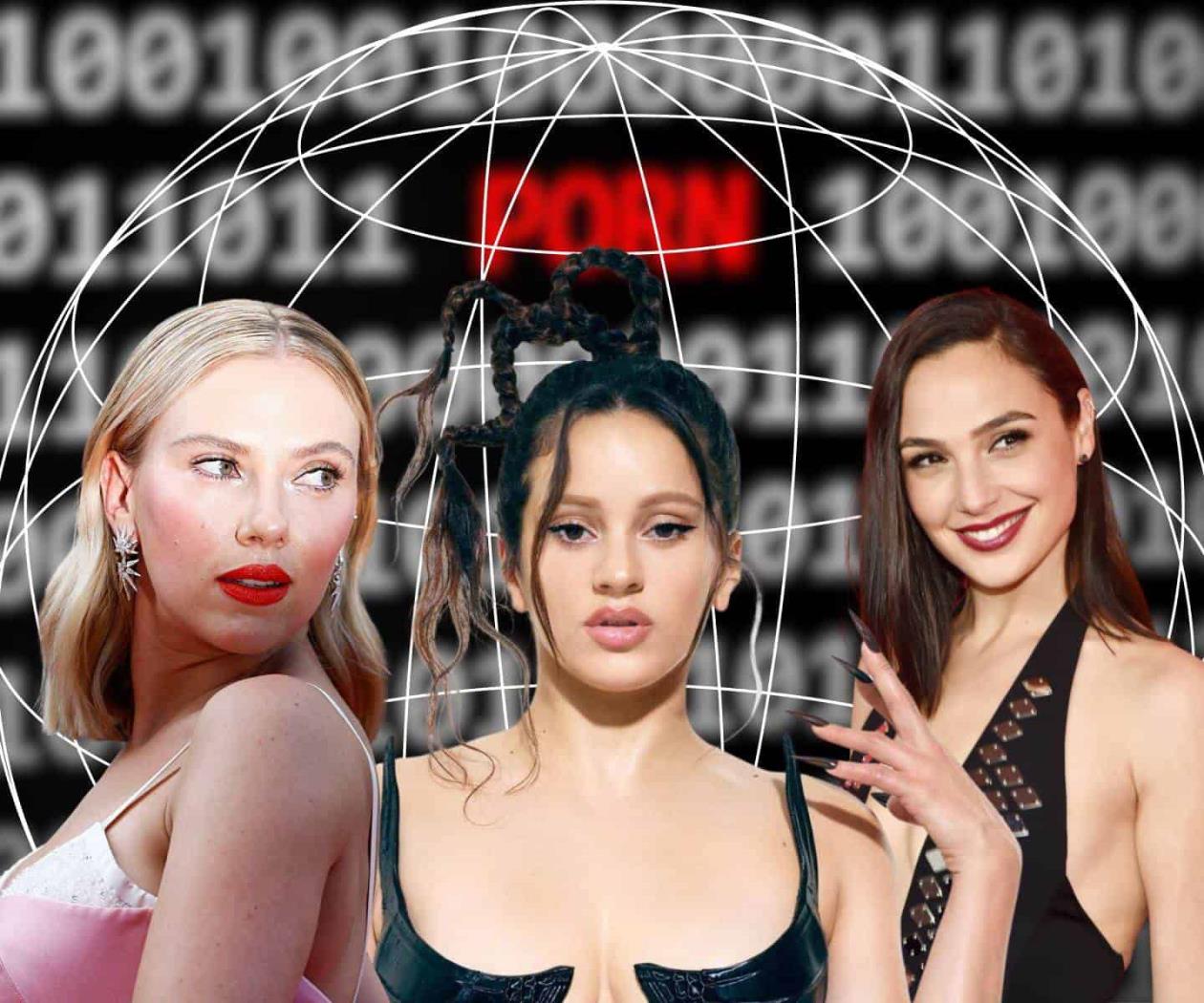

Sólo basta con una búsqueda en internet para que se arrojen más de 700 mil resultados de videos pornográficos de Emma Watson, Maisie Williams, Gal Gadot, Taylor Swift, Scarlett Johansson y muchas otras celebridades. La venta de estos videos en foros como Reddit es altamente redituable y puede costar menos de $500 pesos mexicanos adquirir un video de este tipo y menos de $100 pesos una fotografía explícita, según la BBC.

La última víctima de esta manipulación de contenido fue Rosalía, de quien ha circulado en redes sociales una fotografía intervenida publicada por otro cantante de reguetón, quien utilizó la imagen para promocionar su proyecto. Las y los usuarios de redes sociales intentaron bloquear la difusión de esta deepfake a través de denuncias de contenido, evitar compartir y publicar comentarios masivos para lograr que las imágenes se perdieran entre la inmensidad de personas usuarias.

“El cuerpo de una mujer no es propiedad pública, no es una mercancía para tu estrategia de marketing. Esas fotos estaban editadas y creaste una falsa narrativa alrededor cuando ni te conozco. Existe algo llamado consentimiento y todos a los que os pareció gracioso o plausible espero de corazón que un día aprendáis que venís de una mujer, que las mujeres somos sagradas y que se nos ha de respetar”, se pronunció Rosalía via twitter.

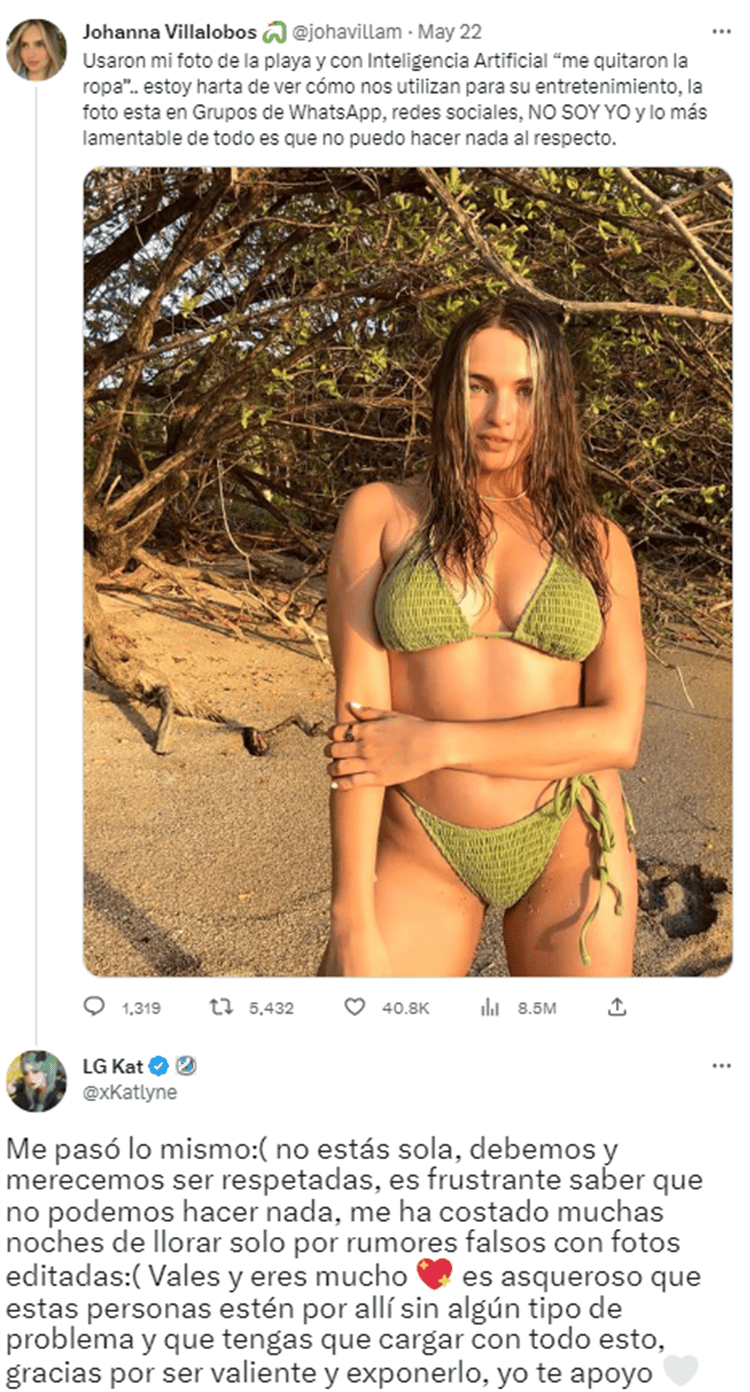

El caso de Rosalía no es el único que ha acontecido en estos días, pues la periodista costarricense Johanna Villalobos también expuso en redes sociales que se había modificado una de sus fotografías en bikini para generar una deepfake.

Derivado de este suceso, se abrió un hilo donde más mujeres dedicadas a la creación de contenido gamer y modelaje denunciaron haber vivido lo mismo, señalando que hasta la fecha, sus fotografías y videos pornográficos continúan divulgándose por todo internet.

¿Qué es la pornografía deepfake y cómo vulnera?

De acuerdo con la BBC, la pornografía o imágenes explícitas sin consentimiento son una violación a los derechos humanos que trasciende cuando los desarrolladores hacen uso de la imagen de personas. Por ejemplo, se genera contenido pornográfico con el rostro de presidentas, periodistas, actrices, escritoras y, en general, de cualquier persona, siempre y cuando exista una persona dispuesta a pagar por ello. Todo con el objetivo de que cualquier usuario que tenga acceso a este contenido (incluso gratuito en páginas pornográficas) pueda fantasear y violentar sexualmente a estas personas sin su consentimiento.

Asimismo, se ha dado el uso de esta tecnología para dañar a exparejas a través de la difusión de supuesto contenido sexual. Sobre esta línea, se puede dar pie a la extorsión, chantaje emocional y violencia psicológica al alcance de un botón.

Esto es apenas el inicio

La generación de imágenes gracias a la inteligencia artificial es algo relativamente novedoso y lo que preocupa en demasía a las empresas desarrolladoras es que, aunque esta herramienta se encuentra dando sus primeros pasos, la pornografía, el sexismo y el contenido sexual explícito se han hecho presentes.

La realidad es que, de manera paulatina, esta herramienta comenzará a perfeccionarse y a alcanzar niveles de realidad sorprendentes que nos harán dudar si todo lo que vemos en internet es verdadero o no. Las deepfakes seguirán estando al alcance de todos, pues anteriormente, podía tomar días generar algún contenido, ahora, sólo se necesita una computadora de buena capacidad para editar, internet y menos de 10 horas para obtener ganancias económicas a costa del cuerpo y rostro de otras personas.

“La realidad es que la tecnología continuará proliferando, continuará desarrollándose y seguirá siendo tan fácil como presionar un botón” (Adam Dodge, fundador de EndTab, grupo que previene y capacita el abuso tecnológico)

Las proyecciones de aquí a cinco años son desalentadoras, por lo que es indispensable la generación de protocolos de protección, la implementación de perspectiva de género y por supuesto, la inclusión de mujeres programadoras que abonen en la prevención de este tipo de violencia, pues al hablar de una herramienta con un impacto tan importante en la humanidad, es impensable que se rompan estereotipos de género, como el de un grupo de hombres programadores que replican comportamientos misóginos y, desde la ginopia, desconocen la posibilidad de entender, reconocer y garantizar la seguridad de las usuarias femeninas. Un ejemplo de esto, es la aplicación gratuita llamada FakeApp desarrollada por un usuario de Reddit que tiene por objetivo crear deepfakes y permitir la pornografía.

"Si quienes enseñan a las computadoras a actuar como humanos son mayoritariamente hombres, entonces, hay una gran posibilidad de que los productos resultantes tengan un sesgo de género. Esto podría explicar por qué su visión del mundo refleja las normas sociales del grupo que las creó (...) cosifica a las mujeres, perpetúa los estereotipos de género y no cuenta con protocolos de protección” (leana Stigliani, catedrática de la Escuela de Nacional del Imperial College de Londres en entrevista para la BBC Mundo)

Con este aumento alarmante de pornografía deepfake e incluso, la creación de OnlyFans de mujeres sin su consentimiento, estas son algunas acciones que han comenzado a tomar las desarrolladoras de IA más importantes a nivel global:

- DALL-E : Eliminó todo contenido explícito de su base de datos para entrenar a la herramienta y que ésta sea imposible de generar contenido de este corte. Además, ha implementado un filtro de las solicitudes y bloquea a todo usuario que intente crear contenido comprometedor con el rostro de figuras públicas.

- Midjourney: Identifica palabras claves que hagan alusión a la pornografía o contenido explícito y bloque a los usuarios. Tiene en marcha una campaña para que sus consumidores denuncien las cuentas de quienes generan imágenes problemáticas.

- Stability IA: Una de las desarrolladoras de IA en ascenso que ha ganado reflectores mundiales, ha implementado en noviembre una actualización que elimina toda imagen sexualmente explícita y limita la facultad de generar este contenido. Estas medidas se implementaron luego de que la compañía fuera señalada de ser una de las principales generadoras de desnudos y deepfake en el internet.