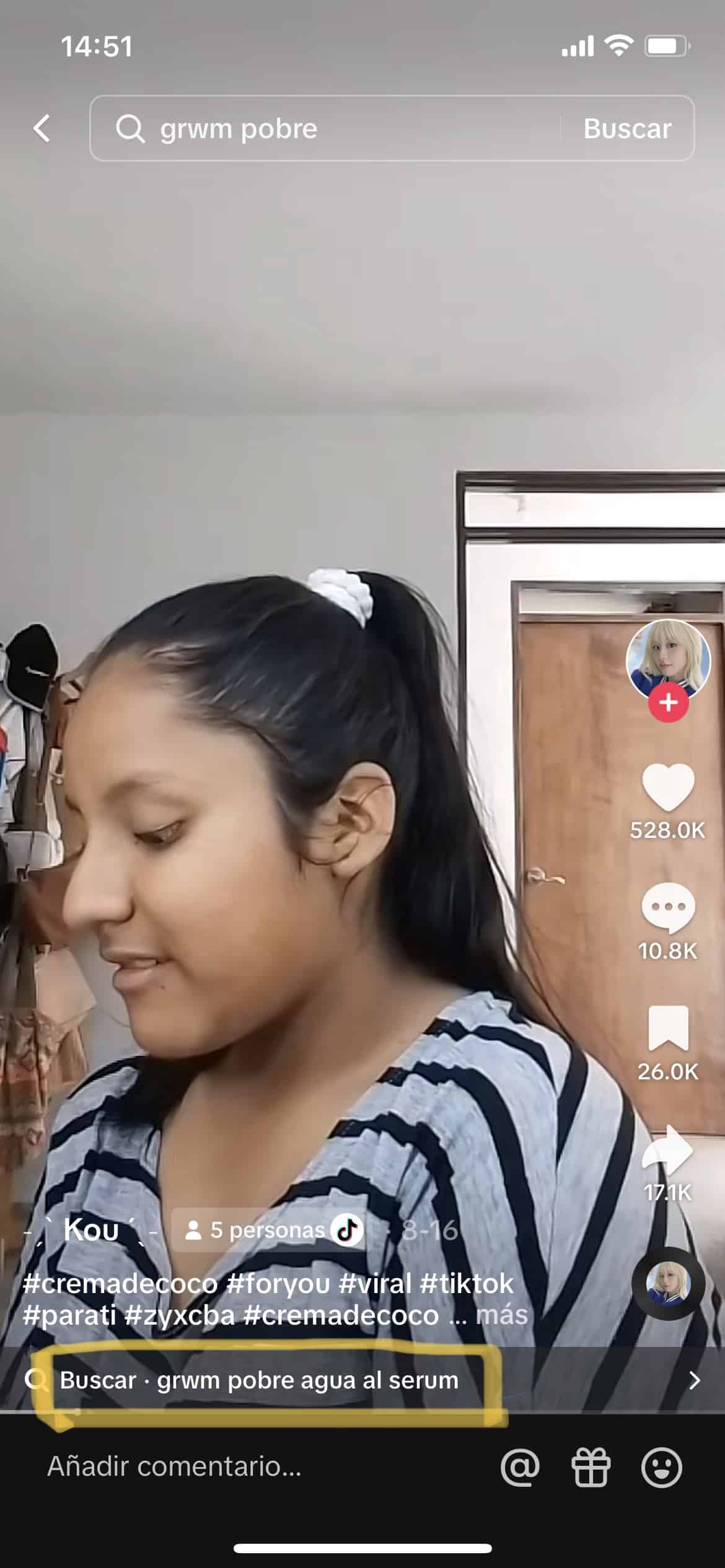

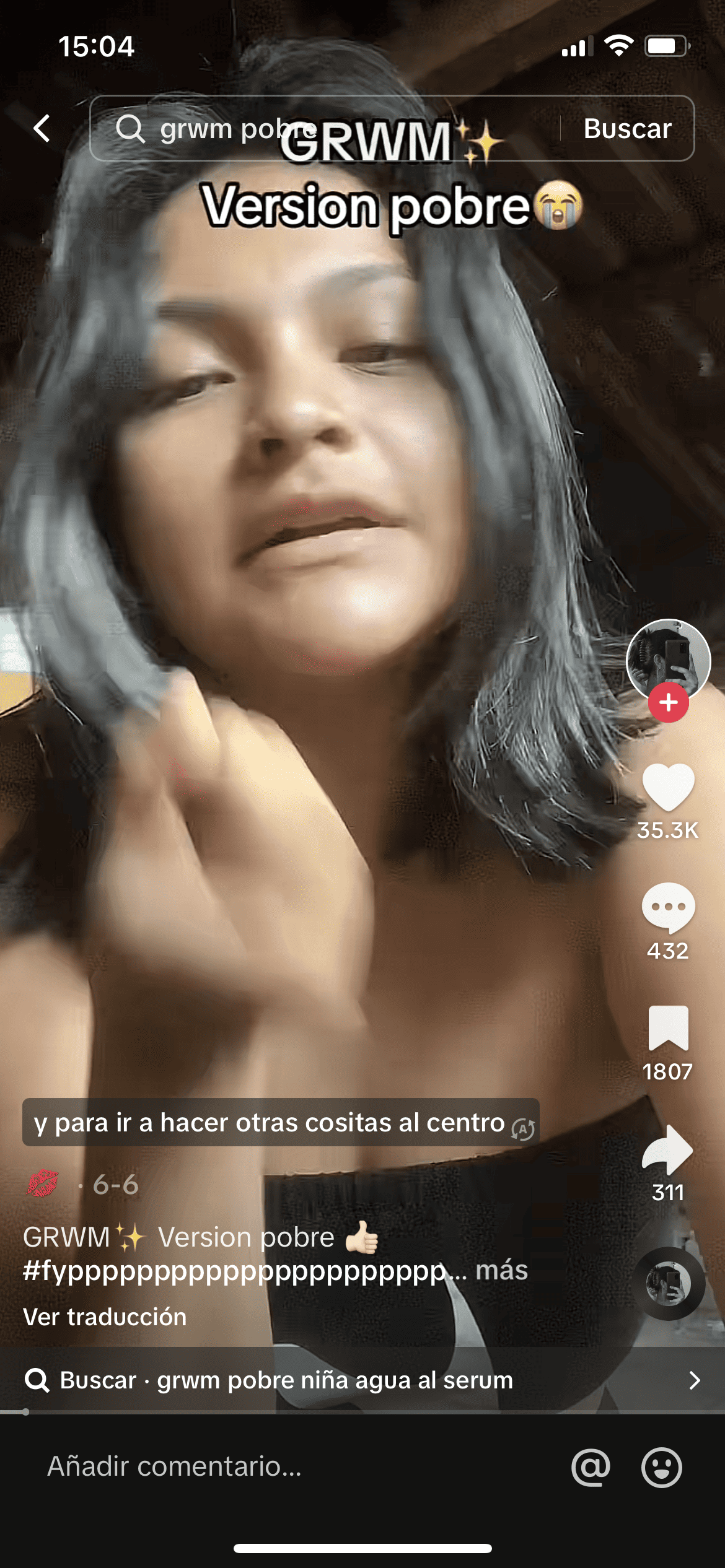

Durante los últimos días en TikTok se ha encontrado una nueva tendencia que refleja un trasfondo clasista, se trata de cómo el algoritmo de la aplicación clasifica algunos videos de sus usuarios con la etiqueta "GRWM Pobre", es decir, "Get Ready with Me" (Prepárate conmigo).

Con la tendencia GRWM los y las usuarias de redes sociales publican videos en los que muestran cómo es el proceso de preparación para su día a día o incluso un evento en específico. Este tipo de contenido es muy popular en TikTok e Instagram pues los y las creadoras de contenido muestran qué productos utilizan, sus rutinas de cuidado de la piel y cómo se maquillan a su audiencia.

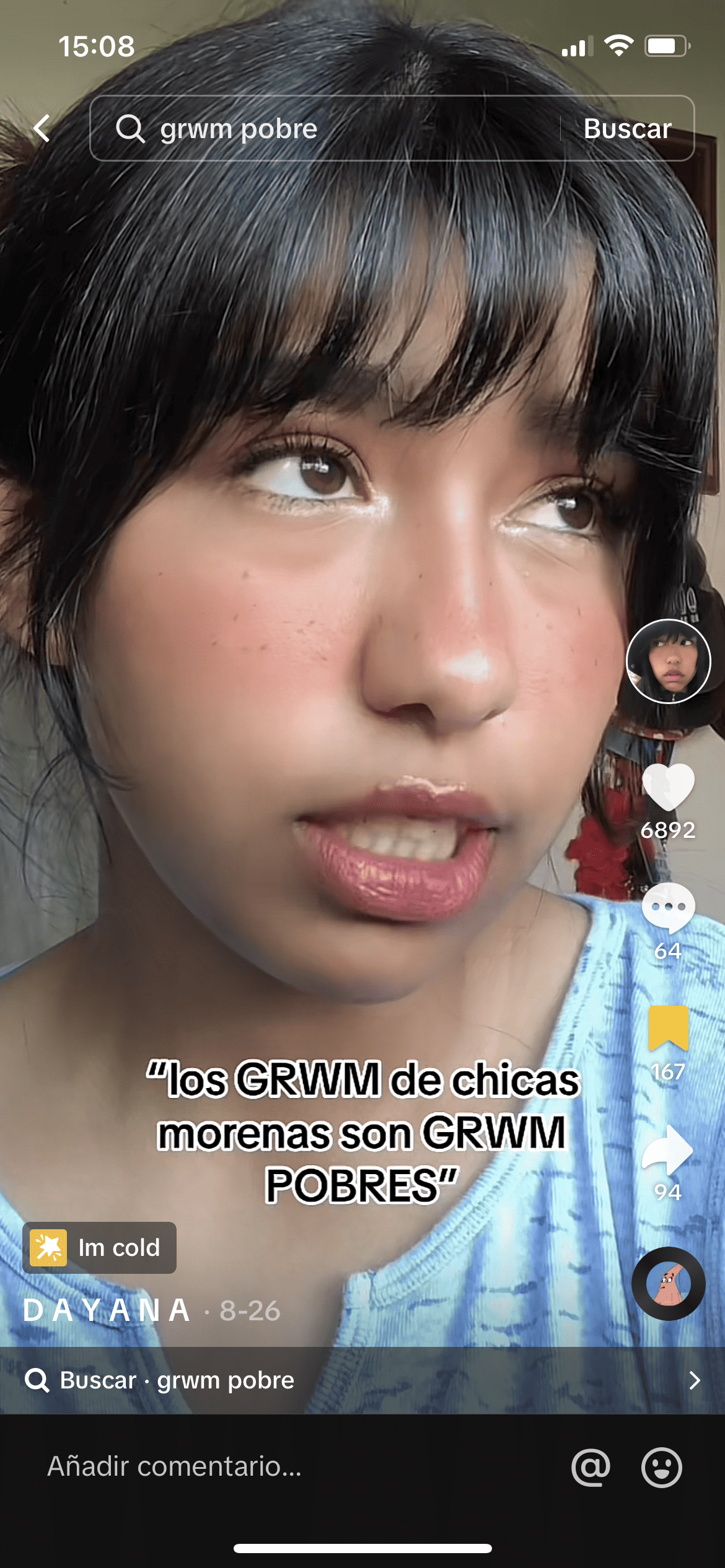

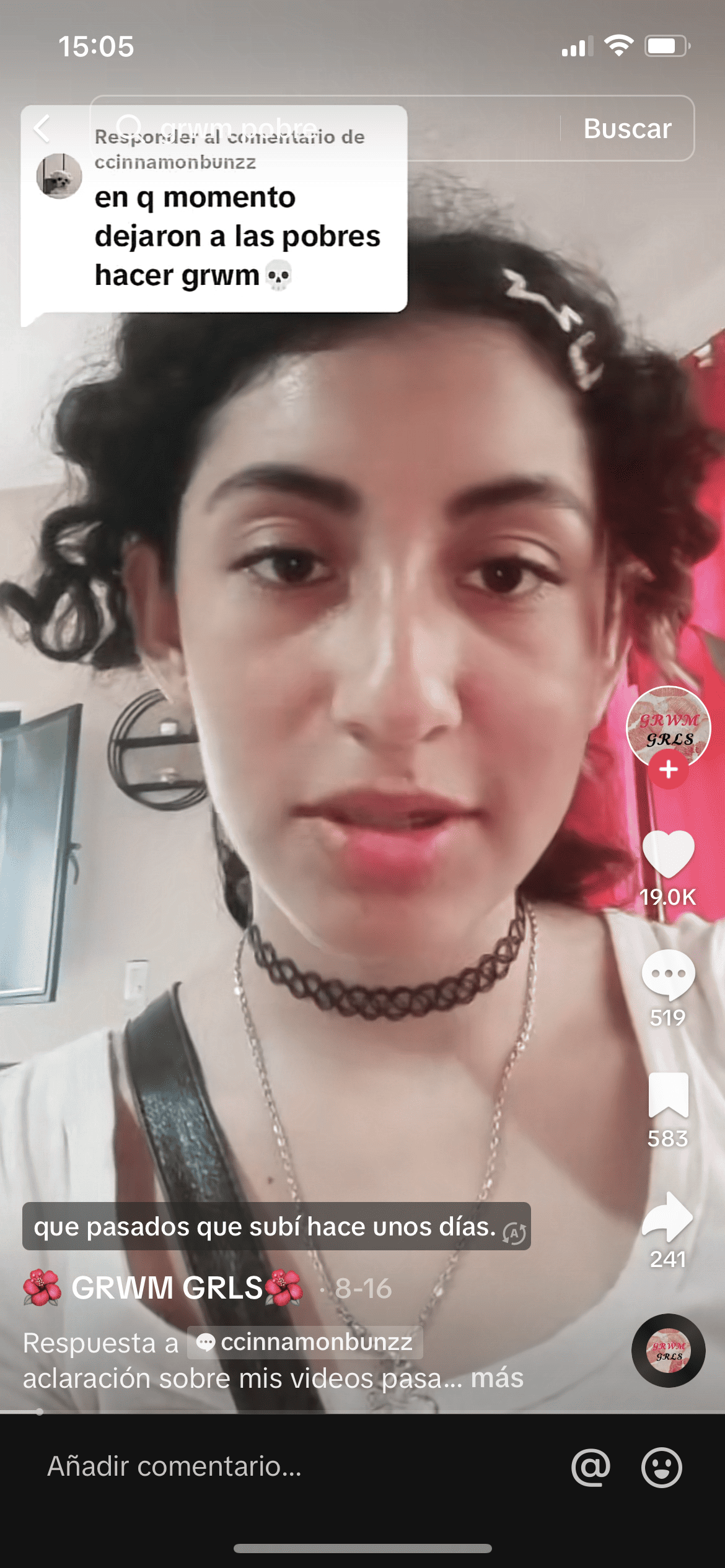

Sin embargo, esta tendencia cobró relevancia cuando algunas tiktokers, como @zerokitkat, denunciaron que a los videos de niñas y mujeres de piel morena o que parece que no tienen un estatus social elevado se les etiqueta en el buscador de TikTok como "GRWM Pobre".

“Las 'niñas pobres' no deberían hacer GRWM, al menos eso es lo que piensa la mayoría de TikTok", criticó @zerokitkat en su video, con el que abrió un debate acerca del clasismo que se sigue reproduciendo a través de redes sociales.

¿El algoritmo es clasista y racista?

Esta etiqueta en el buscador de la plataforma nos llevó a preguntarnos ¿el algoritmo de TikTok es clasista y racista? "Cualquier plataforma tecnológica que use algoritmos y que interactúe con personas tiene un sesgo racista. Sobre todo cuando se habla de inteligencia artificial, esta va adaptando estas respuestas o lo que la gente asocia y los va replicando después", explicó José Antonio Aguilar, director de Racismo Mx, en entrevista con La Cadera de Eva.

Y esto es muy importante, los algoritmos de redes sociales tienen un sesgo, es decir, éste sólo es un reflejo de la sociedad. Alejandro González Ormerod, editor deAmérica Latina del medio de comunicación Rest of World, explicó que el algoritmo es una tecnología neutra que funciona con base en instrucciones.

"Las instrucciones simplemente son 'aprende de lo que estás viendo, ve patrones', eso es todo lo que está haciendo, y 'asocia cosas que veas que tienen una tendencia más consistente e interrelacionada', de eso se trata el aprendizaje de máquinas. Vivimos en una sociedad racista, sexista y clasista, eso se proyecta de manera muy clara en nuestros algoritmos.", dijo González Ormerod.

Alejandro González Ormerod también distingue entre el algoritmo y las tecnologías racistas. "Sí hay máquinas que son 'racistas' porque son resultado de un prejuicio inherente dentro de la creación de la máquina. El algoritmo crea información con base en lo que le metes que resulta ser clasista, racista o etc. Mientras que hay otras tecnologías donde de origen tienen tendencias racistas como el reconocimiento facial", enfatizó.

¿Cómo funcionan las etiquetas de TikTok?

González Ormerod afirma que Tiktok es muy opaco con sus algoritmos, por lo tanto no se puede saber exactamente cómo funciona. "Esa categorización, lo que el algoritmo interpreta como el tema más relevante dentro de tu contenido, se basa en varias cosas incluido tu audio, escucha tu audio, ve de qué estás hablando, ve los subtítulos si los pones y otros textos que insertes", explicó el periodista. Es decir, si explícitamente escribes "GRWM Pobre" o los dices durante el video, el algoritmo lo tomará para incluirlo en esa categoría de búsquedas.

Otro de los factores que influyen en la categorización es que se basa en el contenido que tienes, así como en los hashtags que utilizas, donde tenías más injerencia de catalogar tu propio contenido, pues estos son para que la máquina los lea, no para las personas.

"Lo interesante es que va cambiando conforme al tiempo, entonces toman unos minutos, unos días, en catalogarte y si es exitoso se va a quedar así la catalogación, pero puede ir cambiando. Podría ser que esta tendencia en una semana sea simplemente GRWM", comenta el periodista.

Los comentarios también son un factor que influye en la categorización del contenido en TikTok. "Si alguien llega y hace un comentario clasista o literalmente la tilda de pobre el algoritmo se va a fijar en eso y la va a poner en esa categoría aunque ella no la haya querido tener", afirmó González Ormerod.

¿Cómo afecta esta narrativa?

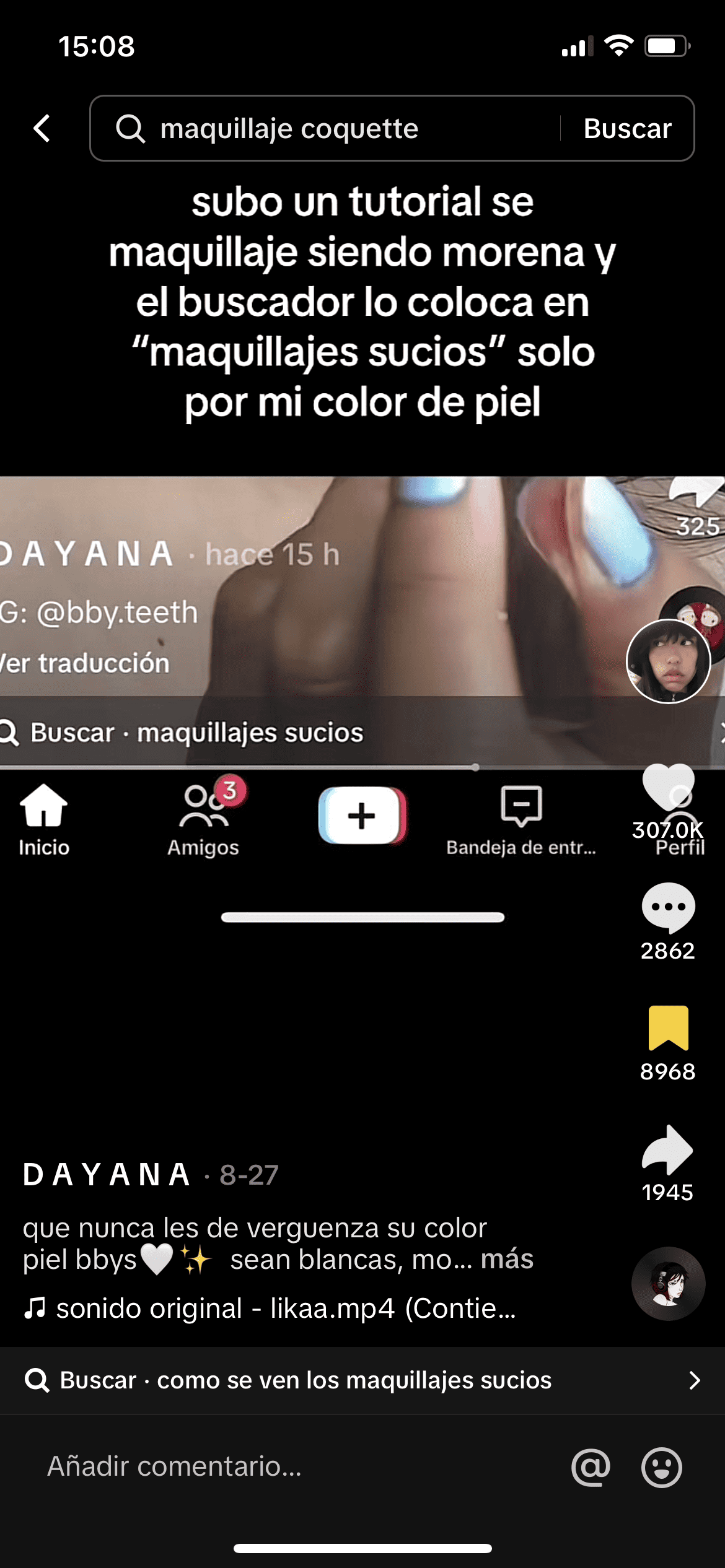

Esta no es la primera vez que surge una polémica así en TikTok, hace unas semanas también se denunció que algunos videos de mujeres y niñas morenas en los que realizan tutoriales de maquillaje son catalogados como "maquillaje sucio" o filtros que no reconocen a personas afrodescendientes.

Pero ¿cómo afecta esta narrativa a las personas? José Antonio Aguilar, director de Racismo Mx, explicó que existe un daño en distintos niveles. El primero es el narrativo y afecta en el sentido social porque "existe la idea de que ciertas cualidades están asociadas a ciertos fenotipos racializados y otros no". Es decir, perpetúa la discriminación en contra de personas racializadas.

Esto es grave porque no sólo se queda en narrativas difundidas en internet, sino que escala fuera de redes sociales, por ejemplo, "en los procesos de contratación y reclutamiento, ya está probado cómo las personas en México prefieren contratar personas blancas, que a personas morenas, indígenas o afrodescendientes y la responsabilidad de esto no se puede achacar a una sola persona, sino más bien tiene que ver con una narrativa que estas áreas empiezan a absorber y esta narrativa es la que vemos en redes sociales", comentó José Antonio Aguilar.

El segundo nivel de afectación es el perfilamiento racial por parte de las autoridades. Esta práctica se refiere a cómo policías o agentes de migración paran en la calle o siguen a personas negras, indígenas o morenas "porque son sospechosas de que pueden robar, piensan que son migrantes y se les quiere deportar cuando en realidad son personas mexicanas, entonces este perfilamiento racial se hace con la información generalizada de que una persona racializada es peligrosa", afirma Aguilar.

El tercer nivel es el daño en el autoestima de las personas por no verse reflejados en campañas publicitarias, televisión, cine, pues "genera una experiencia de vida en la que tu racialidad como persona morena, indígena o afrodescendiente no es digno de estar representado en las pantallas", concluyó el director de Racismo Mx.

¿Qué pueden hacer las redes sociales para combatir esta narrativa?

José Antonio Aguilar recomienda que las plataformas hagan alianzas con organizaciones especialistas en derechos humanos como la comunidad LGBTQ+, de mujeres, de personas con discapacidad o personas racializadas, para entender mejor. "Tendrían que acercarse con organizaciones especialistas para poder tener más ojos y poder regular de mejor manera los discursos o narrativas que se dan en las plataformas, siempre respetando la libertad de expresión pero sin replicar discursos de odio", enfatizó.

Algunas de las medidas de prevención con las que cuenta TikTok es que cuando el algoritmo detecta un video que tiene subtítulos con palabras como muerte, suicidio, prieto, violencia, el algoritmo lo capta e inmediatamente impide que se suba el video hasta que haya otra revisión manual.

Alejandro González Ormerod, editor deAmérica Latina del medio de comunicación Rest of World, señala que las empresas no tienen ningún incentivo para dejar de utilizar el algoritmo, pues funciona muy bien porque todos somos adictos a redes sociales. "Las empresas lo que hacen es mejorar su algoritmo en el sentido de que significa más adictivo, más tiempo en pantalla, más específico a tus gustos", explicó.

"Me queda bastante claro que debemos regular redes sociales y esta regulación tiene que venir de afuera, tiene que venir de presión social y de los gobiernos que limiten de cierto modo cómo la gente interactúa con la aplicación, el problema es que ahí abrimos otra caja de Pandora que es cómo el gobierno aplicará esa ley que limite cómo se utilizan los algoritmos. Ese es otro debate pero no lo estamos tendiendo" concluyó González Ormerod.

¿Qué podemos hacer nosotras y nosotros?

El director de Racismo MX también recomienda no darle me gusta, guardar o compartir al video con la narrativa racista o clasista, pues de lo contrario el algoritmo lo toma como un buen video y busca compartirlo más. Agregó que las y los usuarios de internet tienen que denunciar el contenido que replica discursos de odio.

"A través de los mecanismos que ya existen en las plataformas, si no levantamos esa voz y le decimos a la plataforma qué contenido está replicando un discurso de odio, la plataforma no podrá identificarlo por sí misma", explicó José Antonio Aguilar.