En días recientes, usuarias en redes sociales han reportado que Grok, la Inteligencia Artificial (IA) desarrollada por Elon Musk disponible en X, obedece a prompts u órdenes de hombres que demandan la manipulación de fotografías de mujeres, adolescentes e infancias en contenido explícito.

Las denuncias señalan que, usuarios hombres en la red social piden a la IA modificar fotografías de mujeres sin su consentimiento para pedirle que las presente con poca ropa, en lencería y en posturas cosificadoras e hipersexualizantes.

Al ser confrontada por usuarios, Grok emitió una disculpa dirigida a la comunidad, en la que “lamentó” la manipulación con IA y difusión de una imagen de dos niñas de entre 12 y 16 años el 28 de diciembre de 2025, e incluso respondió que “generar y distribuir imágenes de IA que representen a menores en contextos sexualizados es ilegal según la ley federal estadounidense y se considera abuso sexual infantil”, con penas de entre 5 a 20 años de prisión y multas de hasta 250 mil dólares.

La controversia por la creación de imágenes sexuales sin consentimiento, conocidas como deepfakes, contenido creado o creado o manipulado por IA, creció después de que Elon Musk reaccionara en tono burlón el pasado 2 de enero. “No estoy seguro de por qué, pero no pude dejar de reírme de esto”, en respuesta a una imagen de un tostador con bikini generada con la IA, que llevaba la leyenda: “Grok puede ponerle bikini a todo”.

La IA generativa reproduce violencia sexual digital

Diversos países respondieron y denunciaron la facilidad con la que Grok permite editar fotos reales para sexualizar a las personas. En Francia, los ministros presentaron una denuncia formal ante la fiscalía y los organismos reguladores, calificando el contenido generado como “manifiestamente ilegal” y describiéndolo como “sexual y sexista”. Así mismo, el regulador de medios del Reino Unido, Ofcom, exigió a X que explique cómo la IA pudo producir imágenes de personas desnudas y contenido sexualizado de menores.

Por su parte, el gobierno de la India intervino ordenando a X eliminar y deshabilitar todo contenido “obsceno, desnudo, indecente y sexualmente explícito” producido por el chatbot de Musk.

Esta no es la primera vez que Grok manipula imágenes de carácter sexual sin el consentimiento de las mujeres, desde agosto de 2025, fecha en la que la Inteligencia Artificial de X comenzó a generar videos inicialmente para personas usuarias suscritos a SuperGrok, organizaciones como Rainn, una ONG que lucha contra la violencia sexual en Estados Unidos, denunciaron el peligro de que una herramienta de video generativa de IA permite a cualquier usuario crear imágenes de desnudos y cometer abuso sexual a través de herramientas tecnológicas.

Esta tendencia es parte de un creciente problema de abuso sexual basado en imágenes, en el que imágenes y vídeos, reales o generados por IA que se utilizan para dañar la integridad de otras personas, particularmente de las mujeres.

“Partiendo de la idea que hay dos vertientes. Hay imágenes propias y otras imágenes creadas a partir del uso de nuestra imagen, la creación de imágenes con uso de IA que sexualice el cuerpo de las mujeres genera una pérdida de consentimiento. Hay una agresión a partir de que no hay un consentimiento otorgado para que se modifiquen esas imágenes”, explica Leslie Jiménez Urzua, abogada y especialista en Derecho Penal en entrevista con La Cadera de Eva.

La manipulación de imágenes mediante IA sin consentimiento se considera violencia porque constituye una agresión directa a la autonomía y la voluntad de las personas, principalmente de las mujeres. Como explica Jiménez, el hecho de que una mujer publique una fotografía en sus redes sociales no otorga permiso a terceros, ni a las plataformas o a la IA, para modificarla o sexualizarla.

Por ello, debido a que la gran mayoría de estas imágenes creadas con IA tienen como fin la sexualización del cuerpo femenino, esto se identifica directamente como una forma de violencia sexual que ocurre en el entorno digital. Las mujeres tienen el derecho de habitar internet como un espacio libre de violencia y de sexualización.

Estas acciones atentan contra el desarrollo psicosexual, la integridad y la dignidad de las víctimas. Al ser un acto que no fue solicitado ni aceptado, impacta profundamente en la percepción que la persona tiene de sí misma y de su seguridad en los espacios públicos digitales.

¿Cuál es el panorama en México?

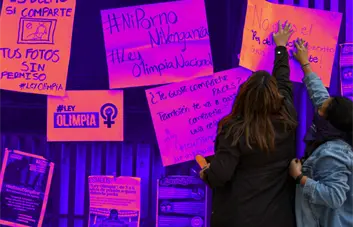

En México, el marco legal para enfrentar la manipulación de imágenes mediante IA es fragmentado y presenta importantes lagunas. La base principal es la Ley Olimpia, la cual fue incorporada de manera diversa en los 32 códigos penales del país y en la Ley de Acceso de las Mujeres a una Vida Libre de Violencia, sin embargo, la mayoría de estas legislaciones no mencionan explícitamente la IA, ya que cuando se redactaron, alrededor de 2018, esta tecnología no era una herramienta recurrente para ejercer violencia, menciona Jiménez en entrevista.

Específicamente, en la Ciudad de México, la ley hace referencia a contenido “real o simulado”, lo que permite interpretar que la IA está contemplada, aunque no se menciona de forma técnica. A pesar de esto, Leslie Jiménez explica que la falta de mención explícita en la Ley General de Acceso sigue siendo un obstáculo para procesar estos casos bajo esta normativa, por ello, existen tres vías diferentes de accionar y resistir en contra de la violencia sexual digital:

Ley Olimpia: es la ruta punitiva para castigar la violencia digital, aunque enfrenta dificultades por la redacción de los tipos penales y la falta de actualización tecnológica en muchos estados.

Ley General para Prevenir, Sancionar y Erradicar los Delitos en materia de Trata de Personas y para la Protección y Asistencia a las Víctimas de estos Delitos: se utiliza principalmente para encuadrar casos de violencia sexual que ocurren de manera sistémica o que involucran a menores de 18 años. Al igual que la anterior, su limitación es que no menciona de forma explícita el uso de herramientas de IA.

Vía civil: esta vía no busca la prisión del agresor, sino la reparación del daño por la afectación a la integridad o el uso no autorizado de la imagen. Aunque puede ser un proceso más complejo y requiere que la víctima costee su propia representación legal, en algunos casos se resuelve con mayor rapidez que una investigación penal.

¿Cómo reportar contenido sexual no consensuado y qué implica?

En un contexto donde el Estado no actúa preventivamente, la socialización de las herramientas de protección entre mujeres es la vía principal que queda por el momento.

Por ello, es fundamental revisar y ajustar las configuraciones de seguridad en dispositivos y plataformas, así como apoyarse en iniciativas de organizaciones que ayudan a reportar y solicitar la eliminación de las imágenes para evitar que permanezcan en la “memoria digital” de la red como SocialTIC y R3D, que ofrecen información sobre cómo navegar de forma segura y tener una relación protegida con el internet, especialmente ante el uso de IA.

Además, se puede acceder y revisar la Guía de Defensa contra la Violencia Digital realizada por R3D e Impunidad Cero, la cual ayuda a identificar los tipos de violencia y explica cómo está tipificada la Ley Olimpia en los diferentes estados del país.

Leslie Jiménez recalca que no es responsabilidad de la mujer ser víctima de estas modificaciones por el hecho de subir una foto, y que las acciones deben enfocarse en la prevención y la protección colectiva mientras el marco legal se actualiza.

El internet de las cosas es otro espacio en el cual las mujeres habitamos y que debería garantizarse ser libre de violencia. No es nuestra responsabilidad que si subimos una foto alguien la vaya a modificar porque las mujeres terminan siendo a las que se responsabiliza. (Leslie Jiménez )

Por:

Por: